Adversarial Attack : Ketika AI Bisa Dikelabui

Dalam

beberapa tahun terakhir, kecerdasan artifisial (AI) telah berkembang pesat dan

diterapkan di berbagai bidang, termasuk pengenalan wajah, diagnosis medis, dan

kendaraan otonom. Namun, di balik kemampuannya yang luar biasa, AI masih

memiliki kelemahan yang dapat dimanfaatkan oleh pihak yang tidak bertanggung

jawab. Salah satu ancaman terbesar terhadap AI adalah adversarial attack

atau serangan adversarial. Serangan ini dapat mengecoh model AI dengan

memanipulasi input yang diberikan, sering kali dengan perubahan kecil yang

hampir tidak terdeteksi oleh manusia, tetapi cukup untuk menyesatkan sistem AI.

Apa

Itu Adversarial Attack?

Sumber

: https://doi.org/10.1080/00031305.2021.2006781

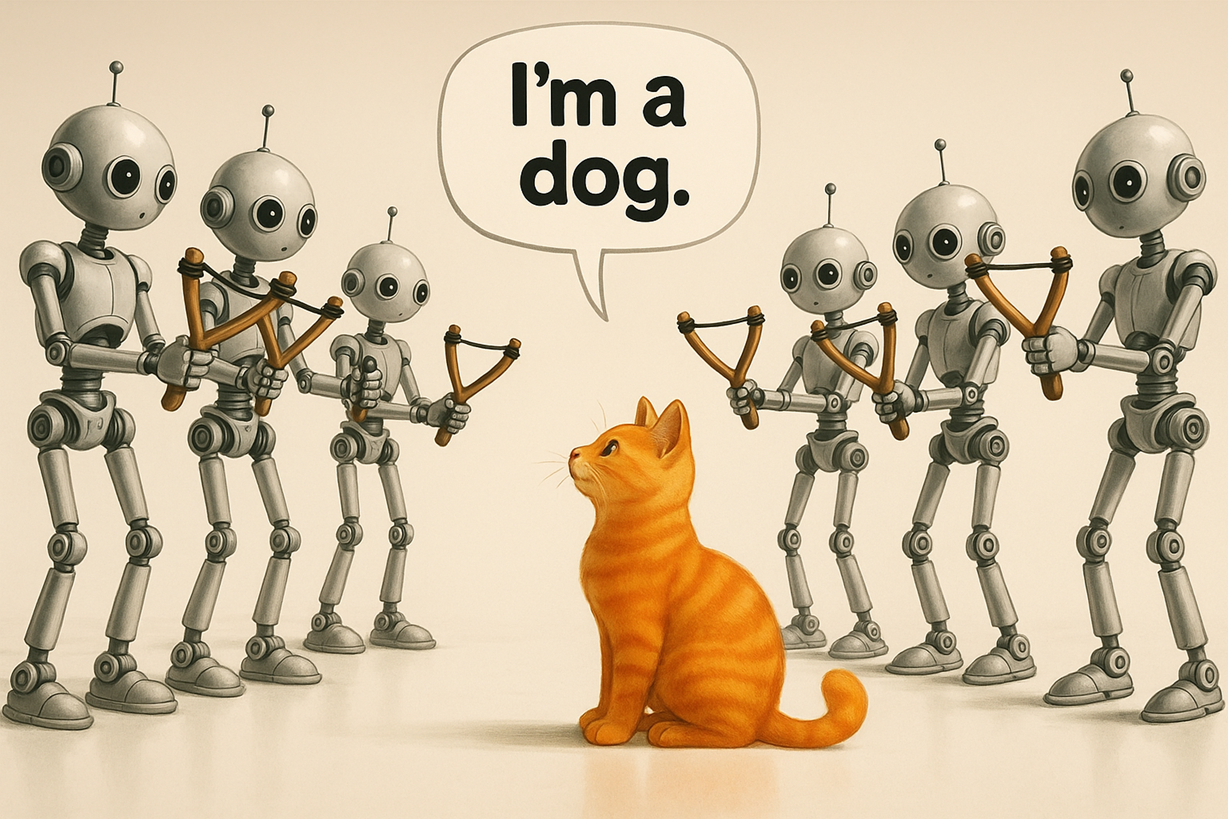

Adversarial attack adalah teknik yang digunakan untuk mengecoh model pembelajaran mesin dengan memberikan input yang telah dimodifikasi secara khusus agar model salah dalam membuat prediksi atau klasifikasi. Input yang dimanipulasi ini disebut sebagai adversarial examples. Serangan ini dapat dilakukan pada berbagai jenis model AI, mulai dari jaringan saraf tiruan (neural networks) hingga model berbasis aturan (rule-based). Sebagai contoh, dalam sistem pengenalan gambar, perubahan kecil pada piksel dalam gambar dapat menyebabkan AI salah mengklasifikasikan objek. Misalnya, gambar panda yang seharusnya diklasifikasikan sebagai "panda" dapat diklasifikasikan sebagai "gajah" setelah ditambahkan gangguan (noise) yang tidak terlihat oleh mata manusia.

Jenis-Jenis

Adversarial Attack

Adversarial attack dapat dikategorikan berdasarkan berbagai faktor, seperti tingkat pengetahuan penyerang terhadap model AI yang diserang dan metode yang digunakan dalam serangan tersebut.

1. Berdasarkan Pengetahuan Penyerang

White-box attack: Dalam serangan ini, penyerang memiliki akses penuh terhadap model AI, termasuk arsitektur, parameter, dan data pelatihannya. Dengan informasi ini, penyerang dapat merancang gangguan optimal untuk menyesatkan model.

Black-box attack: Dalam serangan ini, penyerang tidak memiliki akses langsung ke model AI. Sebagai gantinya, mereka hanya dapat mengamati output model terhadap berbagai input. Dengan menggunakan teknik seperti query-based attack, penyerang dapat memperkirakan parameter model dan menyusun serangan yang efektif.

2. Berdasarkan Metode Serangan

Perturbation-based attack: Serangan ini menambahkan gangguan kecil pada input untuk mengecoh model. Contoh teknik yang digunakan adalah Fast Gradient Sign Method (FGSM) dan Projected Gradient Descent (PGD).

Poisoning attack: Serangan ini dilakukan dengan menyisipkan data berbahaya ke dalam dataset pelatihan, yang membuat model belajar pola yang salah dan menghasilkan prediksi yang keliru.

Sumber

: https://ai.gopubby.com/the-art-of-adversarial-attacks-943b694062dc

Evasion

attack: Model AI dieksploitasi saat sedang beroperasi

dengan memberikan input yang dimanipulasi agar menghasilkan keputusan yang

salah.

Physical attack: Serangan ini dilakukan dalam lingkungan nyata, seperti menambahkan stiker pada rambu lalu lintas agar sistem pengenalan kendaraan otonom salah mengidentifikasi rambu tersebut.

Dampak

Adversarial Attack

Adversarial attack dapat memiliki dampak serius dalam berbagai bidang. Pada sisi keamanan siber, model deteksi serangan siber dapat dibuat tidak efektif dengan serangan adversarial, memungkinkan penyerang melewati sistem keamanan tanpa terdeteksi. Sistem keamanan yang bergantung pada pengenalan wajah dapat dibobol dengan teknik adversarial, misalnya dengan penggunaan pola khusus yang membuat AI salah mengidentifikasi individu. Pada bidang lain seperti penggunaan mobil otonom yang bergantung pada AI untuk mengenali rambu lalu lintas dan pejalan kaki, jika model AI dapat disesatkan oleh adversarial attack, keselamatan penumpang dan pejalan kaki tentu bisa terancam. Model AI dalam bidang medis dapat salah mendiagnosis suatu penyakit jika gambar atau data medis telah dimanipulasi, yang berpotensi membahayakan pasien.

Bagaimana

Cara Melindungi Model AI dari Adversarial Attack?

Untuk mengurangi risiko serangan adversarial, berbagai cara dapat diterapkan, seperti penggunaan adversarial training. Adversarial training adalah teknik melatih model dengan memasukkan adversarial examples ke dalam dataset pelatihan. Dengan cara ini, model dapat belajar mengenali pola-pola manipulasi dan menjadi lebih tahan terhadap serangan. Cara lain adalah dengan teknik Defensive Distillation, yang melibatkan pelatihan model menggunakan soft labels yang dihasilkan oleh model sebelumnya. Hal ini dapat meningkatkan ketahanan model terhadap gangguan kecil yang diberikan oleh penyerang. Beberapa teknik lain seperti preprocessing input, dengan feature squeezing (mengurangi jumlah dimensi fitur) atau noise reduction (menghilangkan gangguan yang tidak diinginkan), dapat membantu dalam mendeteksi dan mengurangi dampak adversarial examples. Selain itu, menambahkan regulasi seperti dropout atau weight decay dalam pelatihan model dapat membantu meningkatkan ketahanan terhadap serangan dengan menghindari overfitting terhadap noise tertentu. Oleh karena itu, penting bagi para peneliti dan praktisi AI untuk mengembangkan strategi pertahanan yang efektif, seperti adversarial training, defensive distillation, dan preprocessing data. Dengan meningkatnya kesadaran terhadap ancaman ini, diharapkan sistem AI dapat menjadi lebih aman dan andal dalam menghadapi berbagai tantangan di masa depan.

-Riskyana-

Sumber

:

https://ai.gopubby.com/the-art-of-adversarial-attacks-943b694062dc

https://pub.towardsai.net/adversarial-attacks-in-textual-deep-neural-networks-245dc90029df

Li, Y., Cheng, M., Hsieh, C. J., & Lee, T. C. M. (2022). A Review of Adversarial Attack and Defense for Classification Methods. The American Statistician, 76(4), 329–345. https://doi.org/10.1080/00031305.2021.2006781